人工智能(AI)行业迎来疯狂的一夜,谷歌(Google)、AMD先后上新,终于要“打爆”OpenAI和英伟达了。

12月7日谷歌CEO桑达尔·皮查伊 (Sundar Pichai) 宣布谷歌公司正式发布迄今为止功能最强大、最通用的多模态人工智能(AI)大模型:Gemini(中文称“双子座”)。

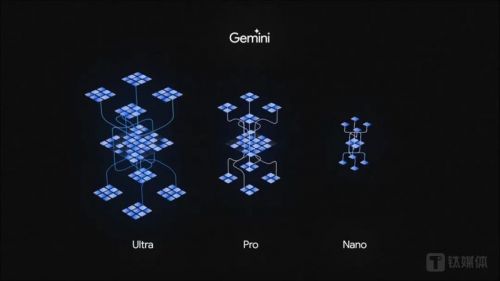

具体来看,谷歌最新发布的Gemini 1.0系列,主要是英语模型,共包括三个不同尺寸版本:Ultra(超大杯)、Pro(大杯)和Nano(中杯),将全面内置最新、最强大的自研 AI 超算芯片Cloud TPU v5p。

谷歌表示,在六项基准测试中,大杯的Gemini Pro性能表现优于GPT-3.5;而在30项性能基准测试中,超大杯Gemini Ultra超越了目前最强模型GPT-4。甚至,Gemini Ultra在MMLU测试上得分高达90.0%,即数学、物理、法律等57个领域测试中,Gemini Ultra成为第一个超越人类专家水平的 AI 模型。

与此同时,12月7日凌晨,芯片巨头AMD在美国圣何塞发布备受瞩目的全新Instinct MI300X AI 加速芯片(APU),由十多个台积电5nm/6nm小芯片组成,拥有1530亿个晶体管,封装CPU+GPU,支持高达192GB的HBM3内存容量,瞄准这一英伟达主导的 AI 算力芯片市场。

皮查伊表示,Gemini是 AI 模型的巨大飞跃,最终将影响几乎所有的谷歌产品。同时,人类正式迎来Gemini新时代的第一步,迈向真正的通用人工智能(AGI Model)。

“MI300X是我们迄今为止最先进的产品,也是业内最先进的 AI 加速芯片。”AMD CEO苏姿丰(Lisa Su)则直示,“AI 是50多年来单一最重要、最具变革性的技术,不止是很酷的新技术,也真切地改变计算世界的未来。”

然而,略带遗憾的是,截至目前,无论是MI300X,还是Gemini 1.0系列模型,都不会在中国大陆市场进行销售和服务,预计AMD或将推出“中国特供”的合规产品。

AMD公司CEO 苏姿丰

谷歌Gemini性能超越GPT-4

最新自研芯片TPU v5p

模型训练速度提高280%

自2022年11月30日起,美国OpenAI公司发布了 AI 聊天机器人 ChatGPT 风靡全球,成为全球增长最快的消费应用之一。它不仅能够写诗、编程,还能创作剧本、协助面试、发表论文,甚至提供广泛的搜索服务,显示出极大的生产力解放潜力。

作为在 AI 技术上投入时间最长并拥有众多核心技术的公司,谷歌面对 ChatGPT 的出色表现和技术优势显得措手不及。市场担忧,ChatGPT 可能会取代传统搜索引擎,对谷歌的搜索广告业务造成影响。

为应对这一挑战,谷歌于今年2月内部发起了内部“红色代码警报”(code red),创始人拉里·佩奇和谢尔盖·布林重回公司,并紧急推出 ChatGPT竞品Bard,以及投资超过4亿美元给ChatGPT竞品 Anthropic。

然而,尽管Bard在发布后进行了多次迭代升级,但市场反馈普遍不佳,认为其产品仓促、性能和体验不及 ChatGPT或微软推出的GPT-4版必应搜索。

如今,谷歌终于准备好反击了,发布了传闻已久的“谷歌杀手锏”、史上性能最强、超越GPT-4的通用 AI 模型Gemini 1.0。

多模态Gemini,是迄今规模最大、能力最强的谷歌大模型,在文本、视频、语音等多个领域超越了GPT-4,是真正的一雪前耻。

据The Information报道称,谷歌本来计划在2024年公布Gemini,但如今,谷歌似乎改变了策略,以在OpenAI经历董事会重组和内部动荡期间抢占舆论焦点。目前谷歌公布的最新论文中,Gemini的研发团队超过800人。

具体到产品中,新的Gemini系列包括三个模型版本:Gemini Ultra(超大杯)、Gemini Pro(大杯)和Gemini Nano(中杯)。

其中,Gemini Ultra(超大杯)是三者中性能最强大的模型,适用于高度复杂的任务,计划明年内置于谷歌聊天机器人Bard中;Gemini Pro(大杯)是最适合在各种任务中通用、可扩展的模型,目前已内测于Bard上;Gemini Nano(中杯)则主要在端侧设备中,执行最高效任务的 AI 模型,将首次用于谷歌Pixel 8 Pro上。

与Bard相比,Gemini和Bard都是 Google AI 开发的大型语言模型(LLMs),但它们有不同的特点和优势。其中,Gemini更擅长生成创意文本格式,例如诗歌、代码、脚本、音乐作品、电子邮件、信件等,而Bard更擅长在挑战性问题下,提供信息和全面的答案。如果用户需要获得信息和全面的答案,Bard将是一个更好的选择。

据谷歌官网介绍,Gemini 1.0亮点主要包括五个方面:最先进的性能测试结果,新的推理以及创意功能,性能强大且高效的 AI 超算系统,责任与安全,以及可用性。

首先,性能测试方面,在32个性能基准测试中的30个中,Gemini Ultra模型超越了现有最先进的GPT-4。其中,在MMLU(大规模多任务语言理解)测试中,Gemini Ultra以90.0%的成绩首次超过了人类专家,这一测试综合了数学、物理、历史等57个科目;此外在UltraMMMU多模态测试中也取得59.4%高分;在图像基准测试中,Ultra未使用OCR就超越了强大的GPT-4V,显示出其多模态和更复杂的推理能力。

新的功能点上,Gemini 1.0 具有复杂的多模态推理能力,可帮助理解复杂的书面和视觉信息,而且它拥有通过阅读、过滤以及理解信息,从数十万份文件中提取见解的卓越能力,将有助于在从科学到金融等多个领域以数字化速度实现新的突破。另外在经过训练之后,Gemini 1.0可以同时识别并理解文本、图像、音频等,且编码能力AlphaCode 2具有巨大的改进,编码性能超过85%的参赛程序员,比前代AlphaCode高出将近 50%。

算力方面,Gemini 1.0 采用谷歌设计的TPUs v4 和 v5e芯片上进行大规模 AI 训练。谷歌称,在TPUs上,Gemini的运行速度明显快于早期规模更小、性能更弱的模型。此外,今天,谷歌还发布迄今为止功能最强大、效率最高且可扩展性最强的TPU系统 Cloud TPU v5p,旨在为训练前沿 AI 模型提供支持,从而将加速 Gemini 的开发。

需要重点提及的是,谷歌TPU v5p芯片采用台积电5nm/7nm工艺,相比前代TPUv4推理芯片,v5p更多是针对生成式 AI 所研发的训练芯片。每个TPU v5p pod(服务器组)都由8960个芯片组成,它通过TPU带宽最高的芯片间互连(ICI)以每秒4800Gbp速度在3D拓扑结构中连接。与TPU v4相比,TPU v5p的Flops性能提高了2倍以上,高带宽内存(HBM)增加了3倍。同时,TPU v5p训练大模型的速度比上一代TPU v4快2.8倍(280%),而借助第二代SparseCores,TPU v5p训练嵌入密集模型的速度比TPU v41快1.9倍以上。

责任和安全方面,谷歌称将致力于负责任地推进 AI,特别是在开发具有先进多模态能力的 Gemini 模型时,依据 Google AI 原则和严格的产品安全政策,增加了新的保护措施,全面考虑潜在风险,并在开发的每个阶段进行测试和风险降低。此外,谷歌与外部专家合作进行压力测试来确保内容安全,且建立了专门的安全分类器来识别和过滤有害内容,确保Gemini更加安全和包容。

可用性方面,谷歌宣布,从今天开始,Bard将使用Gemini Pro 的微调版本来进行更高级的推理、规划和理解,并将以英语版本在170多个国家和地区提供服务(不包括中国大陆),以及计划未来扩展至不同模型和新的语言、地点;另外,从12月13日起,开发者和企业客户可以通过谷歌AI Studio或谷歌云Vertex AI访问Gemini Pro的API,而Gemini Nano则内置于Pixel 8 Pro。

谷歌称,未来几个月,Gemini将应用于谷歌更多的产品和服务,如搜索、广告、Chrome浏览器和 Duet AI。根据测试,在谷歌搜索中内置Gemini,它能够为用户提供更快的搜索生成体验(SGE),用户在美国的英语搜索延迟降低40%,同时在质量方面也有所提高。

谷歌CEO Sundar Pichai(来源:CNBC)

皮查伊表示,这次Gemini的发布对于Bard来说是一个重要时刻,也是Gemini时代的开始。如果测试结果准确,新模型则可能已经使Bard成为像ChatGPT一样优秀。“这显然已经是一个相当令人印象深刻的壮举了。”

不过,截至目前,谷歌搜索和广告业务也未受GPT等大模型的影响。据Statcounter数据,截至2023年10月,必应搜索(Bing)在美国的市场份额略低于7%,较去年同期的7.4%有所下滑;同期谷歌以88.13%的份额继续主导搜索引擎市场。2023年至今,搭载GPT技术的必应搜索的市场份额一直保持在7%以下。同时,财报显示,2022财年,谷歌母公司Alphabet的总营收当中,谷歌搜索及其他收入为 1625 亿美元,同比增长9%。而2023财年前三季度,Alphabet总营收达2210.84亿美元,超过去年同期的2068亿美元。

“迄今为止,我们已经在Gemini上取得了巨大进展。我们正努力进一步扩展其未来版本的各种功能,包括在规划和记忆方面取得进展,以及通过增加上下文窗口来处理更多信息并提供更好的响应。”谷歌表示。

据The Verge报道,谷歌计划明年推出由Gemini Ultra提供支持的“Bard Advanced”预览版——谷歌史上最强大的Chat类产品,有望对标ChatGPT-4或5。

但皮查伊也坦言,虽然 AI 对人类的变革将比火、电力的诞生意义更大,但Gemini 1.0可能不会改变世界,而最好的情况是,Gemini可能会帮助谷歌在生成式 AI 军备竞赛中赶上OpenAI。

“这是 AI 发展过程中的一座重要里程碑,也标志着谷歌迈进新纪元的开始,我们将继续快速创新,并以负责任的方式不断提升我们模型的能力。”谷歌表示。

最强 AI 芯片MI300X

性能比英伟达H100提高60%

但不在中国销售

AMD公司终于决定反击英伟达了。

(图片来源:AMD公司)

北京时间12月7日凌晨,在美国圣何塞举办的AMD Advancing AI 活动上,AMD CEO苏姿丰(Lisa Su)宣布推出Instinct MI300X AI 加速芯片(APU)以及宣布MI300A芯片量产。

两款产品均瞄准这一英伟达主导的市场。

其中,MI300X内存是英伟达H100产品的2.4倍,内存带宽是H100的1.6倍,进一步提升了性能,有望挑战英伟达在炙手可热的 AI 加速芯片市场地位。

具体来说,AMD表示,MI300X新款芯片较英伟达的H100性能最多可以提升60%。在与H100(Llama 2 700亿参数版本)的一对一比较中,MI300X性能提高了高达20%;在与H100(FlashAttention 2版本)的一对一比较中,MI300X性能提高20%;在与H100(Llama 2 70B版本)的8对8服务器比较中,MI300X性能提高40%;在与H100(Bloom 176B)的8对8服务器比较中,MI300X性能提高60%。

与此同时,在 AI 大模型训练中,相比H100,MI300X在 BF16性能基准中提高3.4 倍,INT8精度性能提高6.8倍,1.3倍的FP8和FP16 TFLOPS,从而进一步提升了训练性能。

苏姿丰表示,新款MI300X芯片在训练人工智能软件的能力方面与H100相当,在推理方面,也即软件投入实际使用后运行该软件的过程,要比H100好得多。

针对 AI,AMD共有三大优势,一是具备完整IP与广泛的运算引擎产品组合,可支援从云端、边缘至终端,要求最严苛的工作负载;二是该公司正扩展开源软件能力,以降低进入与使用AI 完整潜力的门槛;第三是AMD正在深化AI合作伙伴的产业体系,让云端服务供应商(CSP)、OEM与独立软体开发厂商(ISV)能享有其先驱性的创新技术。

目前,AMD、英伟达、英特尔三家在全力推进 AI 热潮。其中,英伟达已公布2024年Hopper H200 GPU和Blackwell B100 GPU产品信息,英特尔则将在2024年推出Guadi 3和Falcon Shores GPU,预计未来几年三家公司将持续进行竞争。

AMD称,戴尔、惠普、联想、Meta、微软、甲骨文、Supermicro等公司均会采用MI300系列产品。

其中,微软与AMD合作推出新的Azure ND MI300x v5虚拟机(VM) 系列,该系列针对 AI 工作负载进行了优化,并由MI300X提供支持;Meta公司将在数据中心采用AMD新推的MI300X芯片产品。甲骨文表示,公司将在云服务中采用AMD的新款芯片,预计将在2024年发布。

然而,当前AMD主要面临三个问题:一是AMD产能有限,英伟达和英特尔等厂商都提前买走产能,且AMD推出了 MI300A、MI300X等多个系列产品,或将出现供不应求情况;二是明年3月英伟达将发布B100,H200也将销售到市场,因此AMD独享“最强AI芯片”称号还有多久依然未知;三是软件体系上,CUDA已经成为大模型训练推理的最佳选择,尽管AMD在ROCm软件领域取得显著进步,但相比英伟达CUDA生态ROCm仍很薄弱。

此前市场预计AMD的MI300系列在2024年的出货约为30~40万颗,最大客户为微软、谷歌,若非受限台积电CoWoS产能短缺及英伟达早已预订逾四成产能,AMD出货有望再上修出货量。

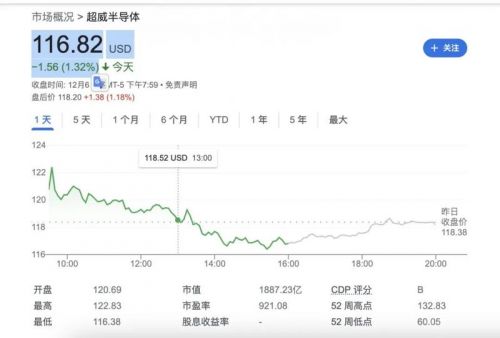

MI300X消息发布后,AMD和英伟达的股价均不涨反跌。

截至美股12月6日收盘,英伟达股价下跌2.28%,AMD股价也下跌1.32%,报收116.82美元/股。年初至今,AMD股价上涨了82.47%,高于英特尔,但远不及增长220%的英伟达股价。

AI超越人类的时代真的到了?

苏姿丰表示,AI 在很短的时间内不仅发展迅速,更是呈现出爆炸性增长,与互联网的发明地位相当。但不同的是,AI 技术的采用速度将会更快。然而目前,我们仍处于 AI 新时代发展的非常早期阶段。

AMD和谷歌这一夜的疯狂成绩告诉我们:AI 时代已经到来,人类必须要关注。而仅仅一年间,一切转变和翻盘,都有可能发生。

随着2023年进入最后一个月,关于大模型的“王座之争”更激烈了。

看向未来, AI 市场将进入一个竞争激烈和快速增长的时期。从医疗保健到汽车行业,对AI大模型有着更高期待,同样AI应用的日益增长需求确保了AI芯片市场的蓬勃发展。未来,我们将会看得到更多创新,也可预见到研发的激增,和更加前沿的技术较量。

一年前,苏姿丰认为,2023年的AI加速器市场为300亿美元。到2027年,全球数据中心AI加速器的潜在市场规模(TAM)将达到1500亿美元,这意味着期间的年复合增长率(CAGR)约为50%。

但现在,苏姿丰直接给出更高的预期,2023年,AI加速器潜在市场规模将达到450亿美元,未来几年的CAGR将高达70%,到2027年,推动整个市场增加到4000亿美元的规模。

当谷歌超越OpenAI、AMD超越英伟达,大模型行业又将迎来怎样的新一轮市场“洗牌”,我们期待,永远相信美好的事情即将发生。