在今年六月于旧金山举行的一场盛大发布会上,AMD CEO Lisa Su 在介绍 MI 300A 之余,还对外公布了公司拥有 1530 亿晶体管的新一代 AI 芯片 MI 300X(参考文章《1530 亿晶体管芯片发布,AMD 正式叫板英伟达》 ) 。因为拥有强大的带宽和内存,叠加人工智能市场被英伟达近乎垄断的现状,AMD 的这颗芯片在发布之后,引起了人工智能从业者的广泛关注。

Lisa Su 在公司 10 月底的三季度的财报会议上更是乐观预测,展望今年第四季度,来自数据中心图形处理单元 ( GPU ) 的收入将达到约 4 亿美元,而随着收入持续增长,到 2024 年这一总额可能会超过 20 亿美元。" 这一增长将使 MI300 成为 AMD 历史上销售额突破 10 亿美元最快的产品,"Lisa Su 表示。

基于这些优越的表现,Lisa Su 在今天的 "Advancing AI" 大会演讲中提高了她对数据中心 AI 加速器的预测。一年前,她认为 2023 年的 AI 加速器市场为 300 亿美元。到 2027 年,全球数据中心 AI 加速器的市场规模将达到 1500 亿美元,这意味着期间的 CAGR 约为 50%。但现在,Lisa Su 认为,AI 加速器在 2023 年的市场规模将达到 450 亿美元,未来几年的 CAGR 将高达 70%,推动整个市场到 2027 年增加到 4000 亿美元的规模。

AMD 还同时揭开了 MI 300X 和 MI 300A 的神秘面纱,还带来了 RCom 6 的更多介绍。

MI300X,全面领先竞争对手

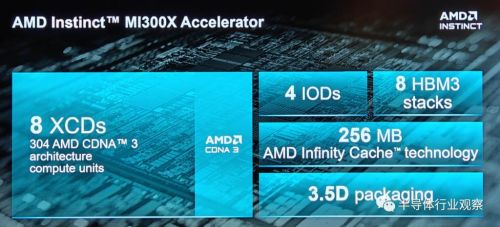

如图所示,AMD Instinct MI300X 采用了 8 XCD,4 个 IO die,8 个 HBM3 堆栈,高达 256MB 的 AMD Infinity Cache 和 3.5D 封装的设计,支持 FP8 和稀疏性等新数学格式,是一款全部面向 AI 和 HPC 工作负载的设计。

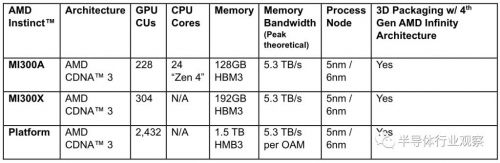

据笔者所了解,所谓 XCD,是 AMD 在 GPU 中负责计算的 Chiplet。如图所示,在 MI 300X 上,8 个 XCD 包含了 304 个 CDNA 3 计算单元,那就意味着每个计算单元包含了 34 个 CU(CU:Computing Unit)。作为对比,AMD MI 250X 拥有 220 个 CU,这也是一个较大的飞跃。

在 IOD 方面,AMD 在这一代的加速器上同样采用了 Infinity Cache 技术,也就是他们所说的 " 海量带宽放大器 "(massive bandwidth amplifier)。资料显示,这是 AMD 在 RDNA 2 引入的技术。当时发布的时候,AMD 方面表示,希望能够借助 Infinity Cache 技术,让 GPU 不但能够拥有可快速访问的高速、高带宽片内缓存,而且还可以同时实现低功耗和低延迟。在 MI 300X,这个缓存的数字提升到了 256MB。与此同时,AMD 还给这个芯片配备了 7×16 路的第四代 AMD infinity Fabric link,为其 I/O 保驾护航。

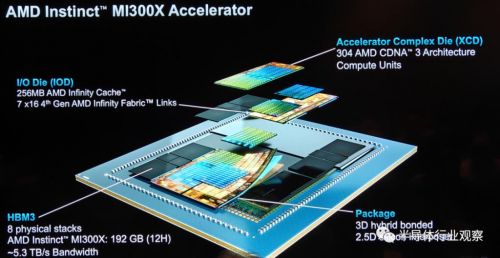

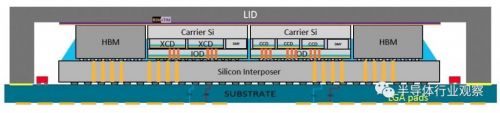

具体到封装方面,AMD 通过引入 3D 混合键合和 2.5D 的硅中介层,实现了一个自称为 "3.5D 封装 " 的技术。

根据 IEEE 在报道中指出,这种集成是使用台积电的 SoIC 和 CoWoS 技术完成的。其中,后者使用所谓的混合键合将较小的芯片堆叠在较大的芯片之上,这种技术无需焊接即可直接连接每个芯片上的铜焊盘。它用于生产 AMD 的 V-Cache,这是一种堆叠在其最高端 CPU 小芯片上的高速缓存内存扩展小芯片。前者称为 CoWos,将小芯片堆叠在称为中介层的较大硅片上,该硅片旨在包含高密度互连中。

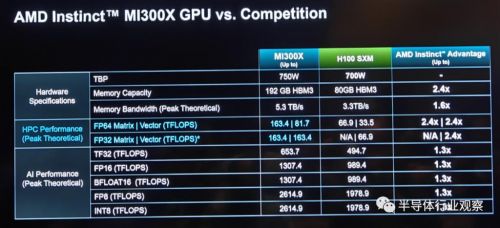

来到 HBM 3 配置方面,通过八个物理堆栈的 HBM,让 MI300 X 的 HBM 容量高达 192GB,是英伟达 H100 80GB HBM 3 的 2.4 倍,这和之前提供的数据一致。但在带宽方面,和上次提供的 5.2TB/s 的不一样,AMD 在新的展示文件中表示,MI 300X 的峰值存储带宽为 5.3TB/s,这是英伟达 H100 SXM(存储带宽为 3.3TB/s)的 2.4 倍。

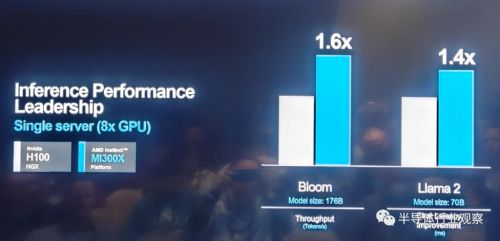

如上图所示,受惠于这些领先的设计,MI300 X 在多个性能测试中领先于竞争对手。而按照他们所说,AMD 在 Instinct 的产品战略方面有四个战略支柱,分别是易于迁移、性能领先、致力于开放和客户聚焦。当中易于迁移是指 MI 300X 将与现在的硬件和软件框架兼容;性能领先则意味着不妥协的领先性能;致力于开放则着重强调了公司投资和积极参与到整个生态系统的开源标准系统中去;客户聚焦则代表着公司以客户为己任,打造适合客户需求的路线图的决心。

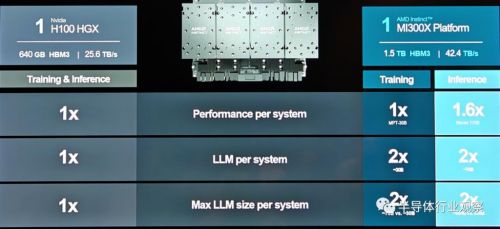

事实上,如图所示,AMD 采用了 8 个 MI 300X 打造了一个拥有优越性能平台,具体参数如下图所示,这也让其成为了业界领先的标准设计。更重要的是,由于该产品的兼容性,使其能够大大降低客户硬件或者软件迁移的时间和成本。

AMD 总结说,基于行业标准 OCP 设计构建的新一代 Instinct 平台配备了八个 MI300X 加速器,可提供行业领先的 1.5TB HBM3 内存容量。AMD Instinct 平台的行业标准设计允许 OEM 合作伙伴将 MI300X 加速器设计到现有的 AI 产品中,并简化部署并加速基于 AMD Instinct 加速器的服务器的采用。

与 Nvidia H100 HGX 相比,AMD Instinct 平台在类似 BLOOM 176b 等 LLM 上运行推理时,吞吐量可提高高达 1.6 倍,并且是市场上能够对 Llama2 等 700 亿参数模型运行推理的唯一选择。

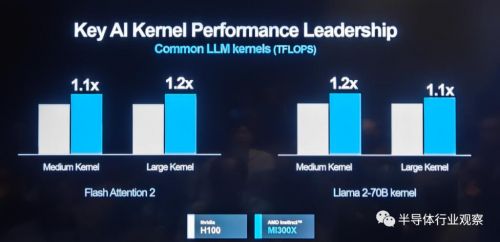

在关键 AI kernel 性能表现上,基于 MI 300X 的平台表现也优于竞争对手。

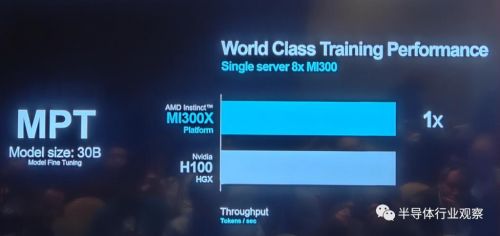

在某些模型的训练上,如下图所示,AMD MI 300X 在和英伟达 H100 相比时也不逊色。

从下图数据,我们则可以看到 AMD 最新芯片平台在训练和推理方面的更多优势。

MI 300A,业界首个 APU 加速器

在这次发布会上,AMD 还深入介绍了业界首个 APU 加速器 MI 300A。

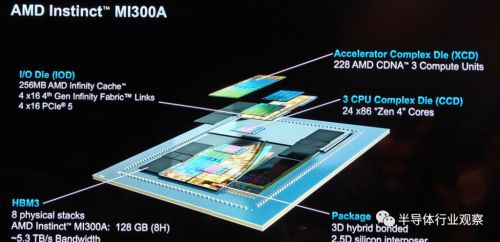

作为全球首款适用于 HPC 和 AI 的数据中心 APU,AMD Instinct MI300A APU 利用 3D 封装和第四代 AMD Infinity 架构,在 HPC 和 AI 融合的关键工作负载上提供领先的性能。MI300A APU 结合了高性能 AMD CDNA 3 GPU 内核、最新的 AMD"Zen 4" 86 CPU 内核和 128GB 下一代 HBM3 内存。与上一代的 AMD Instinct MI250X 相比,在 FP32 HPC 和 AI 上获得约为 1.9 倍的每瓦性能提升。

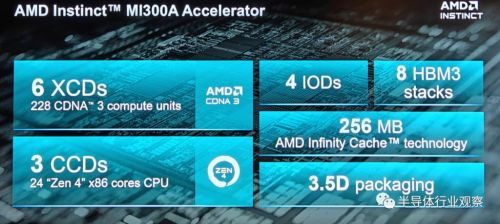

具体到产品设计方面,如上图所示,MI 300A 和 MI 300X 拥有很多的相似之处,例如 3.5D 封装和 256MB 的 AMD infinity Cache 以及 4 个 IOD。但在 HBM 和计算单元方面,也有了不同之处。例如虽然 MI 300A 同样也是采用了 HBM 3 设计,但是其容量大小却小于 MI 300X。

在 I/O die 方面,虽然拥有和 MI 300X 同样的 infinity Cache,但 MI 300A 的 I/O 配置了 4×16 的第四代 Infinity Fabric Link 和 4×16 的 PCIe 5,这与 MI 300X 又有所不同。

对于这两个不同的 MI 300 系列产品,在计算单元方面方面的差距是尤为明显。和 MI 300X 只采用 XCD 计算单元不一样,MI 300A 采用了 6 个 XCD 和 3 个 CCD,这就意味着其拥有 228 个 CDNA 3 CU 和 24 个 "zen 4" 核心。

其实,"CPU+GPU" 的设计并不是 AMD 独家的,例如应为的 GH200,就是采用了同样的概念,英特尔也曾经在 Falcon Shores 上规划了 XPU 的设计。虽然 Intel 取消了 XPU 的设计,但 AMD 依然坚持走在这条路上,因为按照他们之前的说法,从一致内存架构向统一内存 APU 架构的转变,有望提高效率、消除冗余内存副本,且无需将数据从一个池复制到另一个池,以实现降低功耗和延迟的目的。

不过,从 IEEE 的报道也可以看到,英伟达和 AMD 的做法有所不同。在英伟达方面,Grace 和 Hopper 都是独立的芯片,它们都集成了片上系统所需的所有功能块(计算、I/O 和缓存),它们之间是通过 Nvidia NVLink Chip-2-Chip 互连水平连接的,而且很大——几乎达到了光刻技术的尺寸极限。

AMD 则使用 AMD Infinity Fabric 互连技术集成了三个 CPU 芯片和六个 XCD 加速器。而随着功能的分解,MI300 中涉及的所有硅片都变得很小。最大的 I/O die 甚至还不到 Hopper 的一半大小。而且 CCD 的尺寸仅为 I/O die 的 1/5 左右,这种小尺寸带来了良率和成本的优势。

AMD 方面在今日的介绍中也总结说,这种 APU 设计拥有统一的内存、共享的 AMD infinity Catch、动态功率共享(dynamic power shared)和易于变成等优势,这将解锁前所未有的新性能体验。

在实际与 Nvidia H100 的对比中,MI 300A 同样不落下风。例如在 HPC OpenFOAM motorbike 测试中,AMD MI 300A 领先于竞争对手四倍。

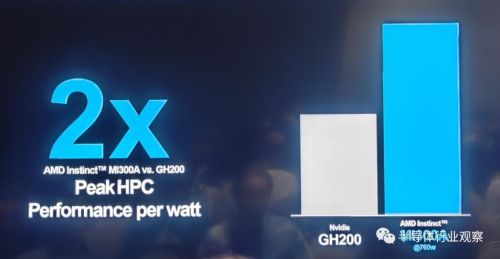

在 Peak HPC 的每瓦性能表现上,MI 300A 更是能做到同为 "CPU+GPU" 封装设计的 Nvidia GH200 的两倍。

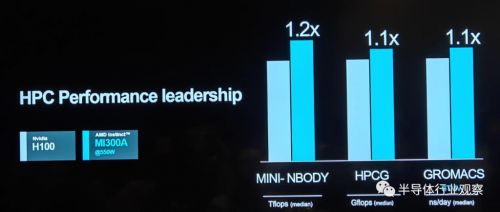

在衡量 HPC 性能的多项测试中,MI 300A 也与 H100 不相伯仲。

正因为拥有如此出色的表现,AMD 的 MI 300 系列获得了客户的高度认可,这也是文章开头 Lisa Su 所披露公司 AI 加速器获得了快速增长订单的根源所在。他们表示,MI 300A 更适合于数据中心和 HPC 应用,例如有望成为世界上速度最快的超级计算机 El Capitan 就是 MI 300A 的客户。至于 MI 300X 则更适合于生成式 AI 的应用场景。AMD 在发布会上也强调,公司这两款产品都受到了客户的高度评价。

无可否认,从过去的多年发展看来,AMD 在硬件方面正在快速更上,且获得了不错的表现。但正如 Semianalysis 分析师 Dylen Patel 所说,对于 AI 加速器而言,所有的魔鬼细节都是体现在软件中。

" 在过去的十年中,机器学习软件开发的格局发生了重大变化。许多框架已经出现又消失,但大多数都严重依赖于利用 Nvidia 的 CUDA,并且在 Nvidia GPU 上表现最佳。"Dylen Patel 强调。他同时指出,在 AMD 方面,其 ROCm 的表现在过去并没有那么好,例如 RCCL 库 ( Communications Collectives Libraries ) 总体来说并没有足够好。

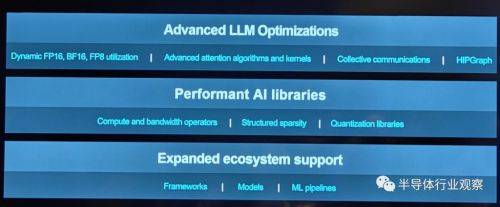

为此,AMD 正在加强公司在软件方面的实力,例如 ROCM 6 就是这次发布会上的一个亮点。

加强软件布局,加紧拓宽客户

AMD 总裁 Victor Peng 在多个场合都强调过,软件非常重要。他甚至认为,软件是 AMD 想要在市场上做出改变的首要任务。

在六月的发布会上,Victor Peng 曾介绍说,AMD 拥有一套完整的库和工具 ROCm,可以用于其优化的 AI 软件堆栈。与专有的 CUDA 不同,这是一个开放平台。而在过去的发展中,公司也一直在不断优化 ROCm 套件。AMD 同时还在与很多合作伙伴合作,希望进一步完善其软件,方便开发者的 AI 开发和应用。

在过去 6 个月中,AMD 也的确取得了一些巨大进展。

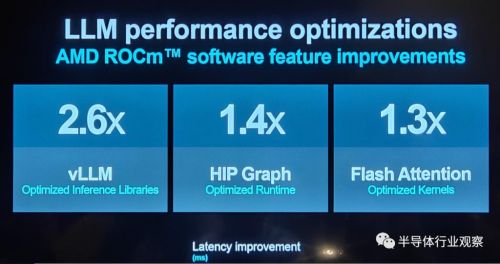

据介绍,AMD 推出了 AMD Instinct GPU 开源软件堆栈的最新版本 ROCm 6,该软件堆栈针对生成式 AI(尤其是大型语言模型)进行了优化。还支持新数据类型、高级图形和内核优化、优化库和最先进的注意力算法(attention algorithms)。

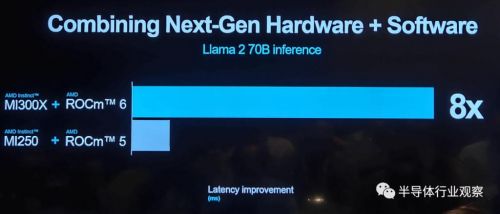

在将 ROCm 6 与 MI300X 一起时,与运行在 MI250 上的 ROCm 5 相比,拥有 70 亿参数的 Llama 2 上文本生成的整体延迟性能提高了约 8 倍。

在参数大小为 130 亿的 Llama 2 做推理性能测试时,MI300X 的延迟表现稍稍优于英伟达的 H100。

在这些软硬件提升支持下,包括 Databricks、Essential Al 和 Lamini 在内的三家构建新兴模型和人工智能解决方案的人工智能初创公司与 AMD 一起讨论了他们如何利用 AMD Instinct MI300X 加速器和开放 ROCm 6 软件堆栈为企业客户提供差异化的人工智能解决方案。最炙手可热的人工智能公司 OpenAl 也宣布在 Triton 3.0 中添加了对 AMD Instinct 加速器的支持——为 AMD 加速器提供开箱即用的支持,使开发人员能够在 AMD 硬件上进行更高级别的工作。

与此同时,微软、Meta、Oracle 也分享了与 AMD 的合作。其中,微软谈到了如何通过部署 MI 300X 来为 Azure ND MI 300X v5 VM 赋能,并优化了其 AI 工作负载;Meta 也在数据中心部署 MI 300X 和 ROCm 6,以实现 AI 推理负载。值得一提的,在于 Meta 的合作中,AMD 还展现了公司 ROCm 6 在 Llama2 上做得一些优化;Oracle 也表示将提供基于 MI 300X 加速器的裸金属计算方案。他们还将在不久的将来提供基于 MI 300X 的生成式 AI 服务。

此外,包括戴尔、惠普、联想、超微、技嘉、Inventec、QCT、Ingensys 和 Wistron 在内的多家数据中心基础设施提供商也都已经或将计划在其产品集成 MI300。

和曾经的数据中心 CPU 市场一样,GPU 市场当前也是一家独大,这是一个公开的秘密。但无论是从市场发展现状、客户需求,或者未来发展需要来看,拥有另外的 AI 加速器供应商是刻不容缓的。

拥有 MI 300 系列的 AMD 无疑是最优的一个候选。让我们期待 Lisa Su 带领这个过去几年在 CPU 领域创造奇迹的团队在 GPU 市场上再创辉煌。